Anthropic 3 聊天

Anthropic Claude 是一系列基础 AI 模型,可用于各种应用程序。 对于开发人员和企业,您可以利用 API 访问并直接在 Anthropic 的 AI 基础设施之上进行构建。

Spring AI 支持 Anthropic Messaging API 进行同步和流式文本生成。

| Anthropic 的 Claude 模型也可通过 Amazon Bedrock Converse 获得。 Spring AI 还提供专用的 Amazon Bedrock Converse Anthropic 客户端实施。 |

先决条件

您需要在 Anthropic 门户上创建一个 API 密钥。

在 Anthropic API 控制面板上创建一个帐户,并在 Get API Keys 页面上生成 api 密钥。

Spring AI 项目定义了一个名为spring.ai.anthropic.api-key,您应该设置为API Key从 anthropic.com 获得。

导出环境变量是设置该配置属性的一种方法:

export SPRING_AI_ANTHROPIC_API_KEY=<INSERT KEY HERE>添加存储库和 BOM

Spring AI 工件发布在 Maven Central 和 Spring Snapshot 存储库中。 请参阅 Repositories 部分,将这些存储库添加到您的构建系统中。

为了帮助进行依赖项管理,Spring AI 提供了一个 BOM(物料清单),以确保在整个项目中使用一致的 Spring AI 版本。请参阅依赖项管理部分,将 Spring AI BOM 添加到您的构建系统中。

自动配置

Spring AI 为 Anthropic Chat Client 提供 Spring Boot 自动配置。

要启用它,请将以下依赖项添加到项目的 Maven 中pom.xml或 Gradlebuild.gradle文件:

-

Maven

-

Gradle

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-anthropic-spring-boot-starter</artifactId>

</dependency>dependencies {

implementation 'org.springframework.ai:spring-ai-anthropic-spring-boot-starter'

}| 请参阅 Dependency Management 部分,将 Spring AI BOM 添加到您的构建文件中。 |

聊天属性

重试属性

前缀spring.ai.retry用作属性前缀,用于配置 Anthropic 聊天模型的重试机制。

| 财产 | 描述 | 违约 |

|---|---|---|

spring.ai.retry.max 次尝试 |

最大重试尝试次数。 |

10 |

spring.ai.retry.backoff.initial-interval |

指数回退策略的初始休眠持续时间。 |

2 秒 |

spring.ai.retry.backoff.multiplier |

Backoff interval 乘数。 |

5 |

spring.ai.retry.backoff.max 间隔 |

最大回退持续时间。 |

3 分钟 |

spring.ai.retry.on-client-errors |

如果为 false,则抛出 NonTransientAiException,并且不要尝试重试 |

假 |

spring.ai.retry.exclude-on-http-codes |

不应触发重试的 HTTP 状态代码列表(例如,引发 NonTransientAiException)。 |

空 |

spring.ai.retry.on-http-codes |

应触发重试的 HTTP 状态代码列表(例如,引发 TransientAiException)。 |

空 |

| 目前,重试策略不适用于流式处理 API。 |

连接属性

前缀spring.ai.anthropic用作用于连接到 Anthropic 的属性前缀。

| 财产 | 描述 | 违约 |

|---|---|---|

spring.ai.anthropic.base-url 的 |

要连接到的 URL |

|

spring.ai.anthropic.version |

Anthropic API 版本 |

2023-06-01 |

spring.ai.anthropic.api-key |

API 密钥 |

- |

spring.ai.anthropic.beta 版本 |

启用新功能/实验性功能。如果设置为 |

|

配置属性

前缀spring.ai.anthropic.chat是允许您为 Anthropic 配置聊天模型实施的属性前缀。

| 财产 | 描述 | 违约 |

|---|---|---|

spring.ai.anthropic.chat.enabled |

启用 Anthropic 聊天模型。 |

真 |

spring.ai.anthropic.chat.options.model |

这是要使用的 Anthropic Chat 模型。支持: |

|

spring.ai.anthropic.chat.options.temperature |

要使用的采样温度,用于控制生成的完成项的明显创造性。较高的值将使输出更具随机性,而较低的值将使结果更加集中和确定。不建议为相同的 completions 请求修改 temperature 和 top_p,因为这两个设置的交互很难预测。 |

0.8 |

spring.ai.anthropic.chat.options.max 代币 |

在聊天完成中生成的最大令牌数。输入标记和生成的标记的总长度受模型的上下文长度限制。 |

500 |

spring.ai.anthropic.chat.options.stop-sequence |

将导致模型停止生成的自定义文本序列。我们的模型通常会在自然完成轮到时停止,这将导致响应stop_reason “end_turn”。如果希望模型在遇到自定义文本字符串时停止生成,可以使用 stop_sequences 参数。如果模型遇到其中一个自定义序列,则响应stop_reason值将为“stop_sequence”,响应stop_sequence值将包含匹配的停止序列。 |

- |

spring.ai.anthropic.chat.options.top-p |

使用细胞核采样。在原子核采样中,我们以降概率顺序计算每个后续标记的所有选项的累积分布,并在达到 top_p 指定的特定概率时将其切断。您应该更改温度或top_p,但不能同时更改两者。仅建议用于高级使用案例。您通常只需要使用 temperature。 |

- |

spring.ai.anthropic.chat.options.top-k |

仅从每个后续代币的前 K 个选项中采样。用于删除 “long tail” 低概率响应。在此处了解更多技术详细信息。仅建议用于高级使用案例。您通常只需要使用 temperature。 |

- |

spring.ai.anthropic.chat.options.tool名称 |

工具列表,由其名称标识,用于在单个提示请求中启用工具调用。具有这些名称的工具必须存在于 toolCallbacks 注册表中。 |

- |

spring.ai.anthropic.chat.options.tool回调 |

用于注册 ChatModel 的工具回调。 |

- |

spring.ai.anthropic.chat.options.internal-tool-execution-enabled |

如果为false,则 Spring AI 将不会在内部处理工具调用,而是将它们代理给客户端。然后,客户端负责处理工具调用,将它们调度到相应的函数,并返回结果。如果为 true(默认值),则 Spring AI 将在内部处理函数调用。仅适用于支持函数调用的聊天模型 |

真 |

(已弃用 - 替换为 |

函数列表,由其名称标识,用于在单个提示请求中启用函数调用。具有这些名称的函数必须存在于 functionCallbacks 注册表中。 |

- |

(已弃用 - 替换为 |

用于向 ChatModel 注册的工具函数回调。 |

- |

(deprecated - 替换为 negated |

如果为true,则 Spring AI 将不会在内部处理函数调用,而是将它们代理给客户端。然后,客户端负责处理函数调用,将它们分派给适当的函数,并返回结果。如果为 false (默认值),则 Spring AI 将在内部处理函数调用。仅适用于支持函数调用的聊天模型 |

假 |

spring.ai.anthropic.chat.options.http-headers |

要添加到聊天完成请求的可选 HTTP 标头。 |

- |

所有前缀为spring.ai.anthropic.chat.options可以通过将特定于请求的运行时选项添加到Prompt叫。 |

运行时选项

AnthropicChatOptions.java 提供模型配置,例如要使用的模型、温度、最大令牌计数等。

启动时,可以使用AnthropicChatModel(api, options)constructor 或spring.ai.anthropic.chat.options.*性能。

在运行时,您可以通过向Prompt叫。

例如,要覆盖特定请求的默认模型和温度:

ChatResponse response = chatModel.call(

new Prompt(

"Generate the names of 5 famous pirates.",

AnthropicChatOptions.builder()

.model("claude-3-7-sonnet-latest")

.temperature(0.4)

.build()

));| 除了特定于模型的 AnthropicChatOptions 之外,您还可以使用通过 ChatOptionsBuilder#builder() 创建的可移植 ChatOptions 实例。 |

工具/函数调用

您可以使用AnthropicChatModel并让 Anthropic Claude 模型智能地选择输出包含参数的 JSON 对象,以调用一个或多个已注册的函数。

这是一种将 LLM 功能与外部工具和 API 连接起来的强大技术。

阅读有关 Anthropic Function Calling 的更多信息。

模 态

多模态是指模型同时理解和处理来自各种来源的信息的能力,包括文本、pdf、图像、数据格式。

图像

目前,Anthropic Claude 3 支持base64的源类型images和image/jpeg,image/png,image/gif和image/webpmedia 类型。

有关更多信息,请查看 Vision 指南。

Anthropic Claude 3.5 Sonnet 还支持pdf的源类型application/pdf文件。

Spring AI 的Message界面通过引入 Media 类型来支持多模态 AI 模型。

此类型包含有关消息中媒体附件的数据和信息,使用 Spring 的org.springframework.util.MimeType以及java.lang.Object对于原始媒体数据。

下面是从 AnthropicChatModelIT.java 中提取的简单代码示例,演示了用户文本与图像的组合。

byte[] imageData = new ClassPathResource("/multimodal.test.png").getContentAsByteArray();

var userMessage = new UserMessage("Explain what do you see on this picture?",

List.of(new Media(MimeTypeUtils.IMAGE_PNG, this.imageData)));

ChatResponse response = chatModel.call(new Prompt(List.of(this.userMessage)));

logger.info(response.getResult().getOutput().getContent());它将multimodal.test.png图像:

以及文本消息“Explain what do you see on this picture?”,并生成如下响应:

The image shows a close-up view of a wire fruit basket containing several pieces of fruit. ...

PDF格式

从 Sonnet 3.5 开始,提供 PDF 支持(测试版)。

使用application/pdfmedia type 将 PDF 文件附加到消息中:

var pdfData = new ClassPathResource("/spring-ai-reference-overview.pdf");

var userMessage = new UserMessage(

"You are a very professional document summarization specialist. Please summarize the given document.",

List.of(new Media(new MimeType("application", "pdf"), pdfData)));

var response = this.chatModel.call(new Prompt(List.of(userMessage)));Samples控制器

创建一个新的 Spring Boot 项目并添加spring-ai-anthropic-spring-boot-starter添加到您的 POM(或 Gradle)依赖项中。

添加application.properties文件中的src/main/resources目录中,以启用和配置 Anthropic 聊天模型:

spring.ai.anthropic.api-key=YOUR_API_KEY

spring.ai.anthropic.chat.options.model=claude-3-5-sonnet-latest

spring.ai.anthropic.chat.options.temperature=0.7

spring.ai.anthropic.chat.options.max-tokens=450将api-key使用您的 Anthropic 凭证。 |

这将创建一个AnthropicChatModel实现,您可以将其注入到您的类中。

下面是一个简单的示例@Controller使用 Chat 模型生成文本的类。

@RestController

public class ChatController {

private final AnthropicChatModel chatModel;

@Autowired

public ChatController(AnthropicChatModel chatModel) {

this.chatModel = chatModel;

}

@GetMapping("/ai/generate")

public Map generate(@RequestParam(value = "message", defaultValue = "Tell me a joke") String message) {

return Map.of("generation", this.chatModel.call(message));

}

@GetMapping("/ai/generateStream")

public Flux<ChatResponse> generateStream(@RequestParam(value = "message", defaultValue = "Tell me a joke") String message) {

Prompt prompt = new Prompt(new UserMessage(message));

return this.chatModel.stream(prompt);

}

}手动配置

AnthropicChatModel 实现ChatModel和StreamingChatModel并使用 Low-level AnthropicApi Client 连接到 Anthropic 服务。

添加spring-ai-anthropic依赖项添加到项目的 Mavenpom.xml文件:

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-anthropic</artifactId>

</dependency>或发送到您的 Gradlebuild.gradlebuild 文件。

dependencies {

implementation 'org.springframework.ai:spring-ai-anthropic'

}| 请参阅 Dependency Management 部分,将 Spring AI BOM 添加到您的构建文件中。 |

接下来,创建一个AnthropicChatModel并将其用于文本生成:

var anthropicApi = new AnthropicApi(System.getenv("ANTHROPIC_API_KEY"));

var chatModel = new AnthropicChatModel(this.anthropicApi,

AnthropicChatOptions.builder()

.model("claude-3-opus-20240229")

.temperature(0.4)

.maxTokens(200)

.build());

ChatResponse response = this.chatModel.call(

new Prompt("Generate the names of 5 famous pirates."));

// Or with streaming responses

Flux<ChatResponse> response = this.chatModel.stream(

new Prompt("Generate the names of 5 famous pirates."));这AnthropicChatOptions提供聊天请求的配置信息。

这AnthropicChatOptions.Builder是 Fluent Options Builder。

低级 AnthropicApi 客户端

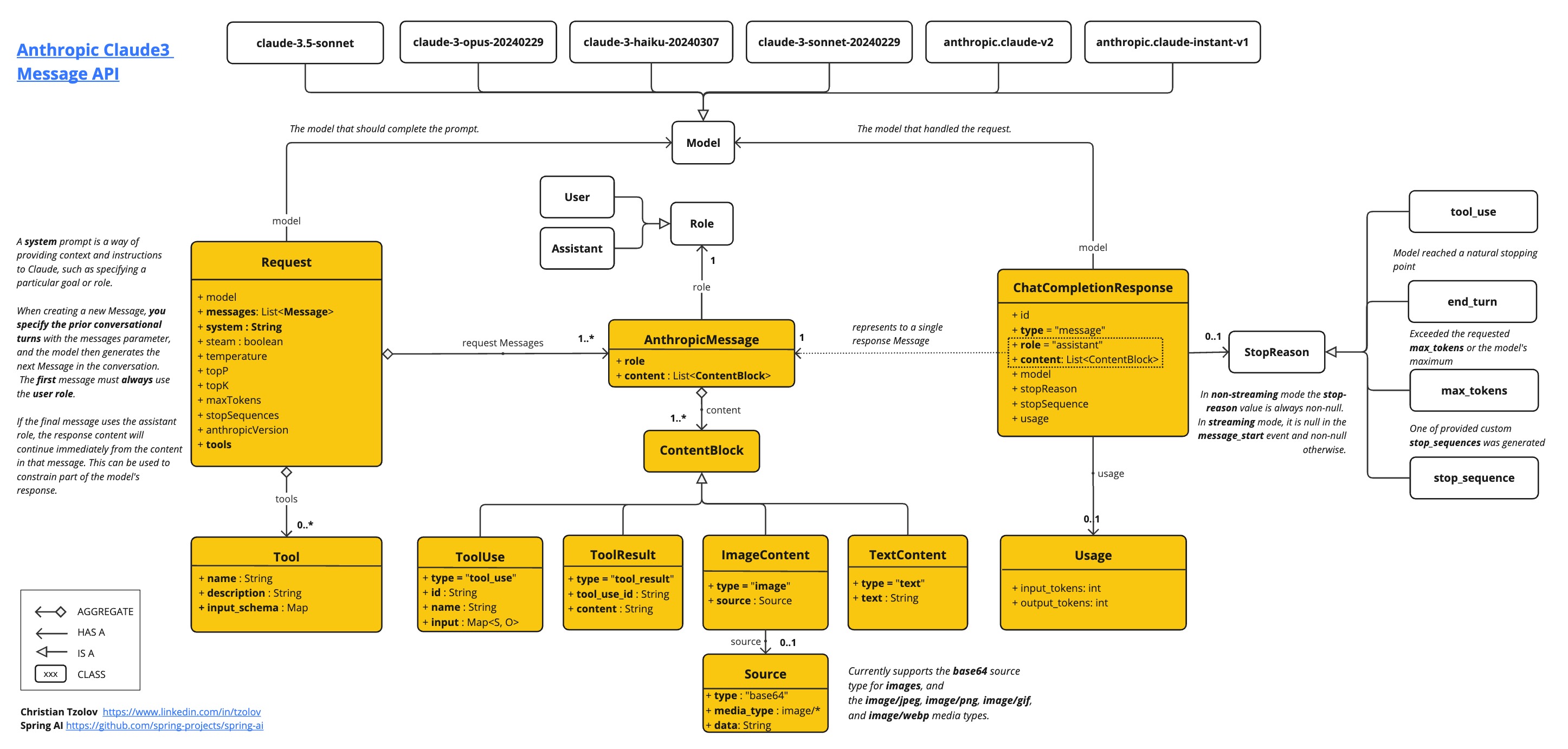

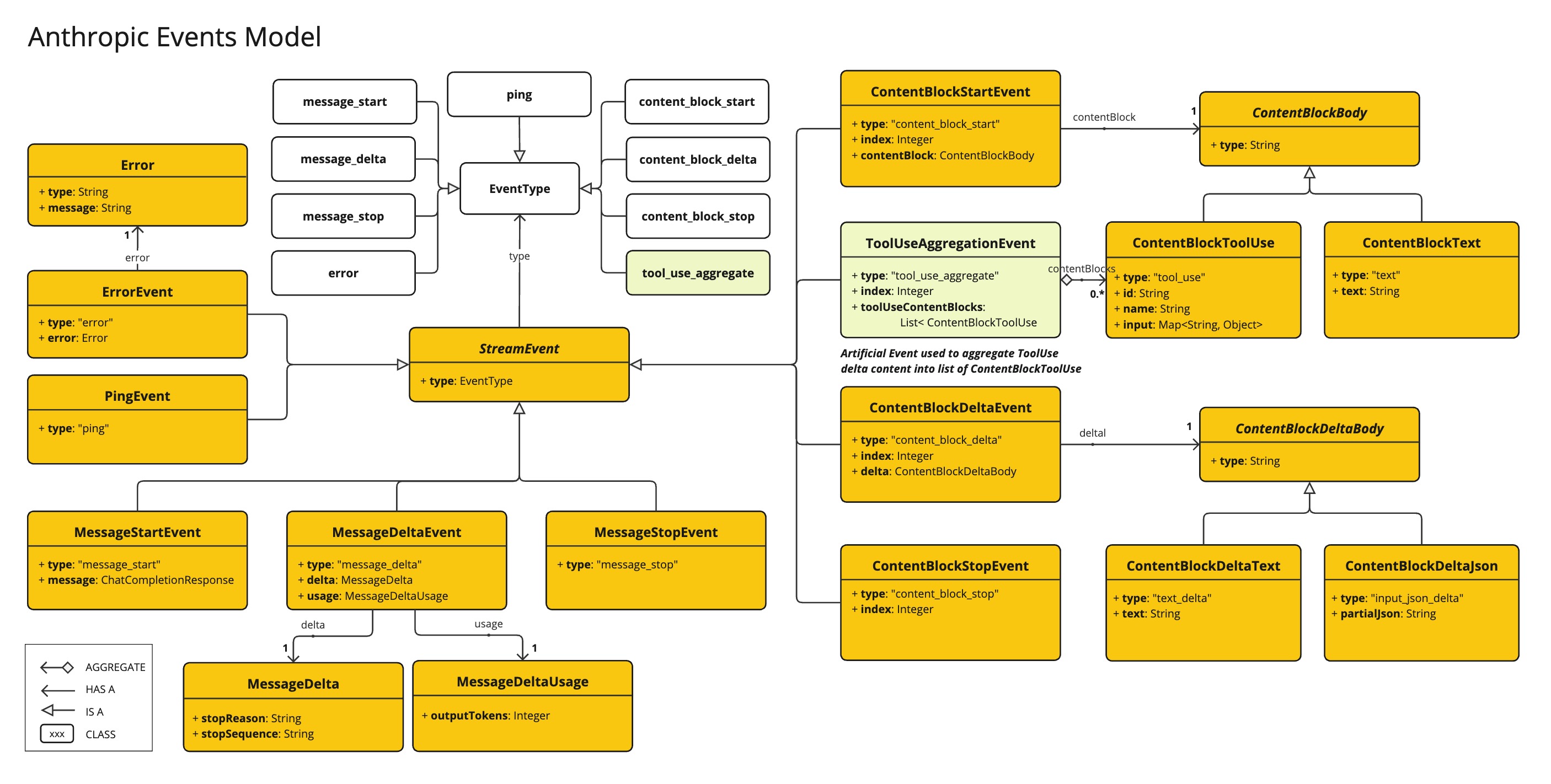

AnthropicApi 为 Anthropic Message API 提供了轻量级的 Java 客户端。

以下类图说明了AnthropicApi聊天界面和构建块:

以下是如何以编程方式使用 api 的简单代码段:

AnthropicApi anthropicApi =

new AnthropicApi(System.getenv("ANTHROPIC_API_KEY"));

AnthropicMessage chatCompletionMessage = new AnthropicMessage(

List.of(new ContentBlock("Tell me a Joke?")), Role.USER);

// Sync request

ResponseEntity<ChatCompletionResponse> response = this.anthropicApi

.chatCompletionEntity(new ChatCompletionRequest(AnthropicApi.ChatModel.CLAUDE_3_OPUS.getValue(),

List.of(this.chatCompletionMessage), null, 100, 0.8, false));

// Streaming request

Flux<StreamResponse> response = this.anthropicApi

.chatCompletionStream(new ChatCompletionRequest(AnthropicApi.ChatModel.CLAUDE_3_OPUS.getValue(),

List.of(this.chatCompletionMessage), null, 100, 0.8, true));有关详细信息,请遵循 AnthropicApi.java 的 JavaDoc。

低级 API 示例

-

AnthropicApiIT.java 测试提供了一些如何使用轻量级库的一般示例。